A inteligência artificial transformou profundamente a forma como interagimos com tecnologia. Hoje, escrevemos uma pergunta, enviamos uma imagem ou até um áudio, e em segundos recebemos uma resposta aparentemente “inteligente”. No entanto, por trás dessa simplicidade existe um conceito técnico fundamental: os tokens.

Portanto, entender o que são tokens ajuda não só a compreender como a IA funciona, mas também por que seu uso é cobrado, como os custos são calculados e de que forma podemos usar essas ferramentas de maneira mais eficiente.

O que são tokens

Tokens são unidades mínimas de informação que os modelos de IA utilizam para processar dados. Em vez de trabalhar diretamente com frases completas, imagens inteiras ou áudios contínuos, a IA divide tudo em pequenos pedaços chamados tokens.

Assim, em textos, um token pode ser:

- uma palavra inteira,

- parte de uma palavra,

- ou até mesmo um conjunto de caracteres.

Por exemplo, a palavra “inteligência” pode virar dois tokens: “inteli” e “gência”, dependendo do modelo. Em inglês, um token costuma representar cerca de quatro caracteres, mas isso varia conforme o idioma e o sistema.

Portanto, tokens funcionam como os “átomos” da informação para a IA.

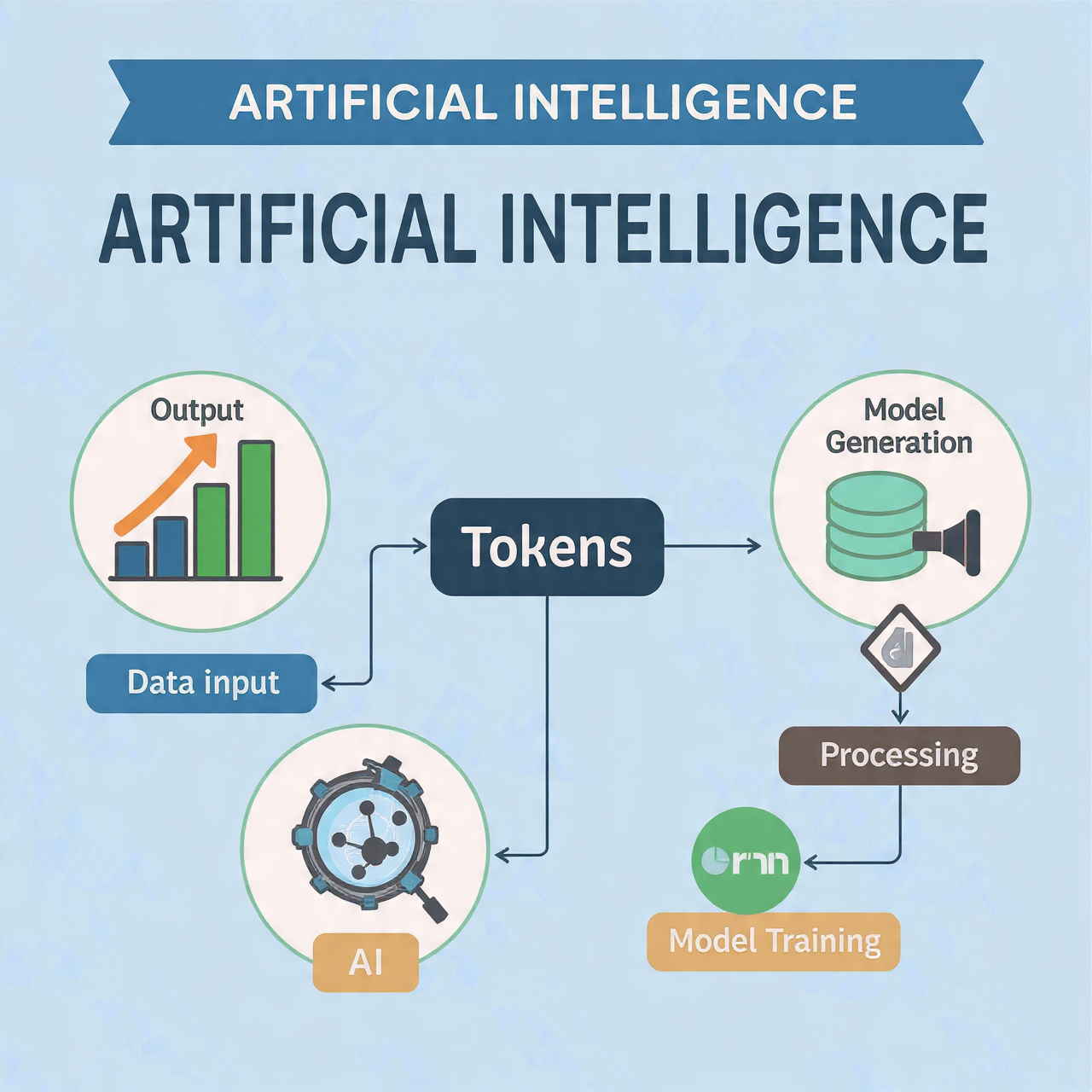

Como os tokens funcionam na prática

O processo que transforma dados em tokens chama-se tokenização. Primeiro, o sistema recebe um conteúdo (texto, imagem, áudio ou vídeo). Em seguida, ele o quebra em tokens. Depois disso, o modelo processa essa sequência e, finalmente, gera novos tokens como resposta.

Ou seja, o fluxo funciona assim:

| Etapa | O que acontece |

|---|---|

| Entrada (input) | O usuário envia texto, imagem ou áudio |

| Tokenização | O sistema divide os dados em tokens |

| Processamento | O modelo analisa os tokens |

| Geração (output) | O modelo cria novos tokens como resposta |

| Reconstrução | Os tokens viram texto, imagem ou som novamente |

Dessa forma, o modelo nunca “vê” frases ou ideias como nós vemos. Ele apenas analisa sequências numéricas representando tokens.

Por que os tokens são tão importantes no treinamento da IA

Durante o treinamento, os modelos de linguagem analisam bilhões ou trilhões de tokens. Eles tentam prever qual será o próximo token em uma sequência. Se acertam, reforçam aquele caminho. Caso errem, ajustam seus parâmetros.

Assim, aos poucos, o modelo aprende padrões linguísticos, relações semânticas e estruturas de significado. Portanto, a IA não entende o mundo como humanos, mas sim como probabilidades entre tokens.

Tokens em diferentes tipos de conteúdo

Nem todo token representa texto. Dependendo do tipo de dado, os tokens assumem outras formas:

| Tipo de dado | Como vira token |

|---|---|

| Texto | Palavras, partes de palavras ou caracteres |

| Imagem | Valores numéricos de pixels e regiões |

| Áudio | Segmentos de ondas sonoras ao longo do tempo |

| Vídeo | Combinação de imagem + movimento + áudio |

Consequentemente, vídeos consomem muito mais tokens do que textos, porque contêm múltiplas camadas de informação.

O que são input e output

O input corresponde ao que o usuário envia ao modelo. Já o output é o que o modelo gera como resposta. Ambos são contados em tokens.

Portanto, uma pergunta curta pode gerar um output grande, e um input longo pode gerar uma resposta curta. Ainda assim, ambos entram no cálculo de uso.

Por que os tokens são usados para cobrar o uso da IA

Os tokens funcionam como uma unidade de medida de esforço computacional. Quanto mais tokens uma tarefa envolve, mais recursos o sistema consome.

Assim como a energia elétrica é medida em quilowatt-hora, a IA mede uso em tokens. Isso torna a cobrança mais justa, porque cada usuário paga apenas pelo que utiliza.

Além disso, como tudo é convertido em tokens (texto, imagem, áudio ou vídeo), o sistema consegue padronizar a cobrança.

Exemplo de custos por milhão de tokens

| Modelo | Input (US$ / milhão) | Output (US$ / milhão) |

|---|---|---|

| Gemini 2.5 Flash | 0,30 | 2,50 |

| GPT-5.2 Pro | 21,00 | 168,00 |

Portanto, gerar conteúdo costuma ser mais caro do que apenas enviar dados, porque exige mais processamento.

O que é processamento em lote (batch processing)

O processamento em lote permite enviar muitas tarefas de uma vez para serem executadas posteriormente. Assim, em vez de exigir resposta imediata, o sistema processa tudo ao longo de horas ou dias.

Como resultado, o custo geralmente é menor, pois as plataformas oferecem descontos para esse tipo de uso.

Como reduzir o consumo de tokens

Você pode reduzir custos seguindo algumas práticas:

| Estratégia | Efeito |

|---|---|

| Escrever prompts mais claros | Menos tentativas, menos tokens |

| Evitar respostas excessivamente longas | Menos output |

| Usar processamento em lote | Menor custo |

| Evitar enviar imagens ou vídeos desnecessários | Menos tokens consumidos |

Portanto, escrever bem também significa economizar.

Os tokens são a base invisível que sustenta toda a inteligência artificial moderna. Eles permitem que textos, imagens, áudios e vídeos sejam transformados em algo que as máquinas conseguem processar.

Além disso, eles explicam por que a IA funciona como funciona, por que ela custa o que custa e como podemos usá-la de forma mais eficiente.

Assim, entender tokens não é apenas um detalhe técnico — é compreender o “idioma” real da inteligência artificial.

E, por isso, quem entende tokens entende melhor o futuro da tecnologia.