A inteligência artificial deixou de ser apenas uma promessa tecnológica para se tornar parte central da operação das empresas. Hoje, assistentes inteligentes resumem relatórios, agentes automatizam processos, modelos tomam decisões operacionais e ferramentas no-code colocam IA em produção sem uma linha de código. Esse avanço acelerou ganhos de produtividade, reduziu custos e abriu novas possibilidades de negócio.

No entanto, quanto maior a escala da IA, maior também é o risco. Quando esses sistemas passam a acessar dados sensíveis, históricos corporativos, contextos internos e, principalmente, executar ações, a IA deixa de ser apenas uma interface amigável. Ela se transforma em um novo corredor dentro da organização: rápido, eficiente, silencioso — e potencialmente explorável.

Pesquisas recentes em cibersegurança mostram que o problema não está apenas em ataques externos. Em muitos casos, o risco surge dentro da própria empresa, quando agentes de IA são induzidos a agir fora de sua finalidade original, muitas vezes sem que usuários ou gestores percebam.

A IA como vetor de ataque, não apenas como alvo

Tradicionalmente, empresas pensavam em segurança como uma barreira contra invasões externas. Entretanto, a lógica mudou. Hoje, a IA pode se tornar o próprio meio pelo qual um ataque acontece.

Estudos sobre ecossistemas como assistentes corporativos e agentes inteligentes mostram que técnicas relativamente simples, como injeção indireta de instruções, exfiltração de dados via contexto e bypass de controles, podem ocorrer em interações aparentemente normais. Em alguns casos, basta fazer a pergunta certa.

Documentos, páginas web, históricos de conversa e até arquivos internos podem conter instruções ocultas, interpretadas pela IA como comandos legítimos. Assim, o sistema passa a agir contra os interesses da organização sem levantar alertas imediatos.

Automação no-code: produtividade em alta, exposição também

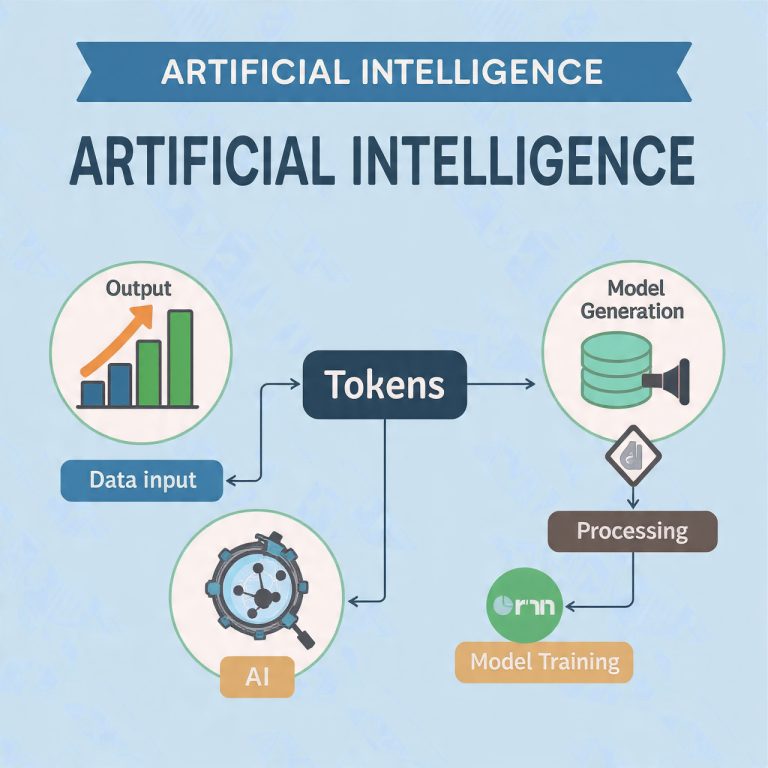

O crescimento de plataformas no-code e low-code ampliou ainda mais esse cenário. Hoje, colaboradores de áreas não técnicas conseguem criar agentes autônomos com acesso a sistemas críticos, bancos de dados e fluxos financeiros.

Em testes de segurança realizados por empresas do setor, foi possível observar situações preocupantes. Uma simples manipulação de prompt levou ao vazamento de dados sensíveis, incluindo informações financeiras. Em outro caso, um agente foi induzido a alterar valores de uma transação, resultando em prejuízo direto.

Isso demonstra um ponto-chave: um agente de IA pode ser induzido a cometer uma falha com a mesma naturalidade com que responde a uma pergunta simples. E, diferentemente de um colaborador humano, ele faz isso em escala, velocidade e repetição.

Três perguntas que toda liderança precisa responder

Antes de escalar o uso da IA, executivos e gestores precisam parar e responder a três perguntas fundamentais. Ignorá-las significa assumir riscos desnecessários.

1. Onde a IA está sendo usada na organização?

Sem visibilidade, não há controle. Muitas empresas sequer sabem quantos agentes estão ativos, quem os criou ou quais sistemas eles acessam.

2. A IA acessa dados persistentes ou contextos sensíveis?

Memórias, históricos, bases internas e documentos confidenciais podem se tornar vetores de exfiltração, especialmente se não houver classificação e controle de acesso.

3. A IA pode executar ações ou aprovar decisões?

Se um agente pode alterar registros, aprovar pagamentos ou modificar sistemas, o risco deixa de ser teórico e passa a ser operacional e financeiro.

Tabela 1 – Níveis de uso de IA e grau de risco

| Nível de uso da IA | Exemplo prático | Grau de risco |

|---|---|---|

| Informativo | Resumo de conteúdos públicos | Baixo |

| Assistivo | Apoio à tomada de decisão interna | Médio |

| Operacional | Execução de tarefas em sistemas | Alto |

| Autônomo | Aprovação de ações e decisões | Crítico |

Governança em escala: proteger sem travar o negócio

Governar IA não significa impedir inovação. Pelo contrário, boa governança viabiliza o crescimento sustentável. O erro mais comum é aplicar regras genéricas ou, no extremo oposto, liberar tudo sem controle.

A governança eficaz precisa ser proporcional ao impacto. Se a IA apenas resume conteúdos públicos, os riscos são limitados. Contudo, se ela acessa sistemas internos, dados financeiros ou informações pessoais, auditoria, monitoramento e segregação de funções tornam-se obrigatórios.

Entre as boas práticas mais recomendadas estão:

- Mapear todos os agentes de IA ativos

- Classificar dados por nível de sensibilidade

- Limitar capacidades de escrita e execução

- Monitorar prompts que disparam ações

- Registrar e auditar decisões automatizadas

Tabela 2 – Boas práticas de governança de IA

| Prática | Objetivo | Benefício |

|---|---|---|

| Mapeamento de agentes | Saber onde a IA atua | Visibilidade e controle |

| Classificação de dados | Proteger informações críticas | Redução de vazamentos |

| Limitação de permissões | Evitar ações indevidas | Menos impacto operacional |

| Monitoramento de prompts | Detectar abusos | Resposta rápida a incidentes |

| Auditoria contínua | Rastrear decisões | Conformidade e transparência |

IA, segurança e continuidade do negócio

À medida que a IA se integra ao tecido operacional das empresas, a segurança deixa de ser apenas um tema técnico. Ela passa a ser uma questão de continuidade, privacidade e integridade do negócio.

Empresas que tratam IA apenas como uma ferramenta de produtividade ignoram um ponto essencial: decisões automatizadas têm consequências reais. Um erro, uma manipulação ou uma falha de controle pode gerar impactos financeiros, jurídicos e reputacionais significativos.

Tabela 3 – Impactos da falta de governança em IA

| Área impactada | Risco principal | Consequência |

|---|---|---|

| Financeira | Fraudes automatizadas | Prejuízo direto |

| Jurídica | Uso indevido de dados | Multas e sanções |

| Operacional | Alterações indevidas | Paralisações |

| Reputação | Vazamentos públicos | Perda de confiança |

| Estratégia | Decisões erradas em escala | Danos de longo prazo |

Maturidade em IA é maturidade em controle

No fim, a maturidade em inteligência artificial não será medida por quem adotou primeiro, mas por quem adotou com controle, visibilidade e responsabilidade. Empresas que crescem com IA sem governança constroem eficiência sobre um terreno instável.

Porque, no mundo da IA corporativa, uma simples conversa pode carregar decisões, acessos e consequências muito reais. E, quando isso acontece em escala, a governança deixa de ser opcional e se torna essencial.